-

Reward Design with Language Models연구/논문리뷰 2024. 12. 14. 15:43

2024년 8월 27일 화요일 리뷰

- 개인 연구를 위해 논문을 리뷰한 내용입니다:)

https://arxiv.org/abs/2303.00001

Reward Design with Language Models

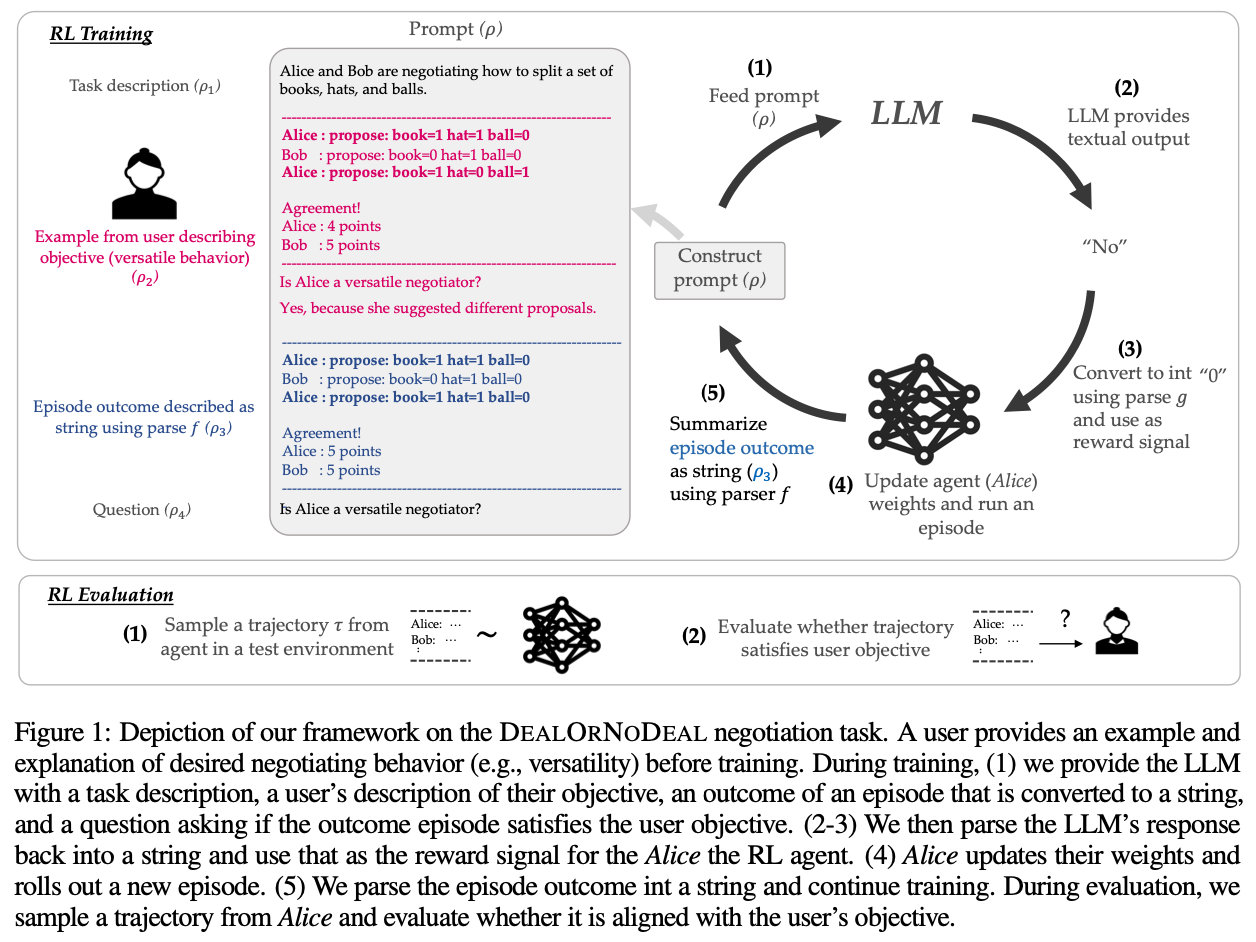

Reward design in reinforcement learning (RL) is challenging since specifying human notions of desired behavior may be difficult via reward functions or require many expert demonstrations. Can we instead cheaply design rewards using a natural language inter

arxiv.org

RL에 있어서 보상함수 구성부분에 LLM을 집어넣은 논문이다.

이 논문에서도 prompt가 중요해 보인다.

최근 RL에 LLM을 접목시켜 성능을 향상시키는 논문들이 나오고 있는데, RL에 있어서 중요한 부분은 MDP 구성인 만큼 이 부분을 건들이는 것 같다.

MDP에서 state를 LLM으로 뽑아낸다던지, Action에서 Decision Making으로써 LLM을 사용한다던지, 이 논문 처럼 Reward 구성을 LLM으로 대체한다던지 등등 여러 논문들이 나온다.

본 논문은 보상 '자체'를 LLM으로 뽑아내는 구성이다.

LLM으로 Yes (or No) 가 output으로 나오면 이를 1(or 0)으로 변환하여 RL에게 보상으로 전달해준다.

'연구 > 논문리뷰' 카테고리의 다른 글